AI的三大关键基础要素是数据、算法和算力。随着云计算的广泛应用,特别是深度学习成为当前AI研究和运用的主流方式,AI对于算力的要求不断快速提升。CPU可以拿来执行AI算法,但因为内部有大量其他逻辑,而这些逻辑对于目前的AI算法来说是完全用不上的,所以,自然造成CPU并不能达到最优的性价比。因此,具有海量并行计算能力、能够加速AI计算的AI芯片应运而生。

01

AI芯片的分类,承担任务(训练、推理)

AI的实现包括两个环节:训练、推理。所以根据承担任务的不同,AI芯片可以分为:用于构建神经网络模型的训练芯片,利用神经网络模型进行推理预测的推理芯片。

训练,是指通过大数据训练出一个复杂的神经网络模型,即用大量标记过的数据来“训练”相应的系统,使之可以适应特定的功能。训练需要极高的计算性能,需要较高的精度,需要能处理海量的数据,需要有一定的通用性,以便完成各种各样的学习任务。

推理,是指利用训练好的模型,使用新数据推理出各种结论。即借助现有神经网络模型进行运算, 利用新的输入数据来一次性获得正确结论的过程。也有叫做预测或推断。

区分训练和推理最简单的例子就是训练芯片在不断做着1+1+1+1+1.....而推理芯片则将加法变成了乘法。训练芯片,注重绝对的计算能力,而推断芯片更注重综合指标, 单位能耗算力、时延、成本等都要考虑。训练将在很长一段时间里集中在云端,推理的完成目前也主要集中在云端,但随着越来越多厂商的努力,很多的应用将逐渐转移到终端。推理相对来说对性能的要求并不高,对精度要求也要更低,在特定的场景下,对通用性要求也低,能完成特定任务即可,但因为推理的结果直接提供给终端用户,所以更关注用户体验方面的优化。

而随着终端产生的数据量越来越多,为了能够更好地处理这些数据,互联网厂商对于推理芯片的需求量也将会逐年增加,对于推理芯片的性能要求也将会逐年增加。

02

AI芯片市场的发展

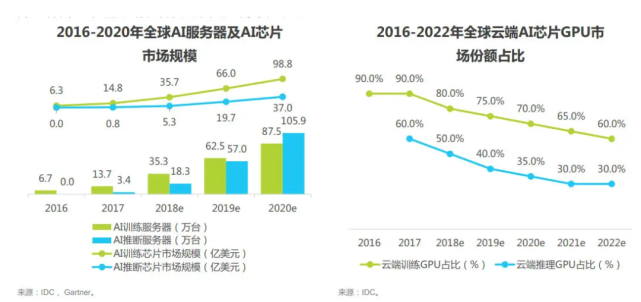

当前互联网公司对于数据的处理大部分需求仍然是算力为主,因此英伟达等企业占据了AI芯片的主流市场,主要原因是它们的芯片拥有强大的并行计算能力(相比CPU)、通用性以及成熟的开发环境。2020年全球AI服务器市场规模为122亿美元,预计到2025年全球AI智能服务器市场将达到288亿美元,5年CAGR达到18.8%。

但是,随着全球互联网数据的迅猛增长,导致互联网企业对算力的需求成指数级上升,对大量的不同数据的不同处理需求成指数级上升。这使得原有的CPU、GPU对应框架逐渐无法跟上企业需求。现有的芯片运行框架无法应对庞大数据量的并行计算、处理要求。

应运而生的AI芯片即为半定制化FPGA芯片以及全定制化ASIC芯片。FPGA、ASIC等加速芯片,利用CPU与加速芯片的组合可以满足高吞吐量互联的需求,为自然语言处理、计算机视觉、语音交互等人工智能应用场景提供强大的算力支持,已经成为人工智能发展的重要支撑力量相比于传统CPU服务器,在提供相同算力情况下,搭载AI芯片的服务器在成本、空间占用和能耗分别为传统方案的1/8、1/15和1/8。

从AI芯片的市场份额占比来看,GPU的市场份额在逐渐下降,那么可以确定的是未来FPGA、ASIC这些拥有定制属性的芯片会成为互联网公司采用的主流芯片。这一点从近年来国内各大互联网厂商分分下场参与芯片制造事件也有所体现。无论是百度、阿里这些自行成立芯片公司,还是腾讯、字节等对外投资AI芯片公司都反映出了市场对AI芯片的需求已经处于一个非常急迫的节点。

03

新未来,新机遇

在市场如此追捧AI芯片的浪潮下,国内一众AI芯片企业当中已经有一部企业从中脱颖而出,逐渐有了领域的领头羊的姿态。在此格局下我们更应关注像希姆计算、燧原科技等已形成强有力的市场竞争优势的企业。这些企业会随着市场对AI芯片需求的增加而逐渐壮大,企业价值增长会更加迅猛。